AIACC-Inference(AIACC推理加速)支持优化基于TensorFlow和可导出ONNX格式的框架搭建的模型,能显著提升推理性能。本文介绍如何自动安装AIACC-Inference(AIACC推理加速)并测试demo。

背景信息

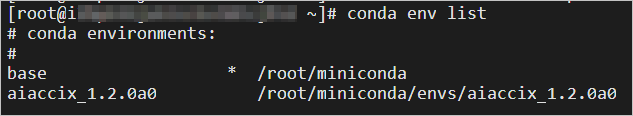

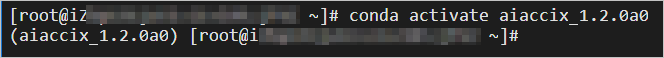

Conda是一款开源跨平台的软件包和环境管理系统,Miniconda是一款小巧的Conda环境部署工具。创建GPU实例时支持自动安装包含AIACC-Inference(AIACC推理加速)的Conda环境,您可以使用Miniconda快速选择不同的Conda环境,并通过AIACC-Inference(AIACC推理加速)显著提升推理性能。

ONNX是一种开放式的文件格式,用于存储训练好的模型。通过ONNX可以将不同框架(例如Pytorch、MXNet)的模型数据存储成统一的格式,便于在同一环境下测试不同框架的模型。

自动安装AIACC-Inference(AIACC推理加速)

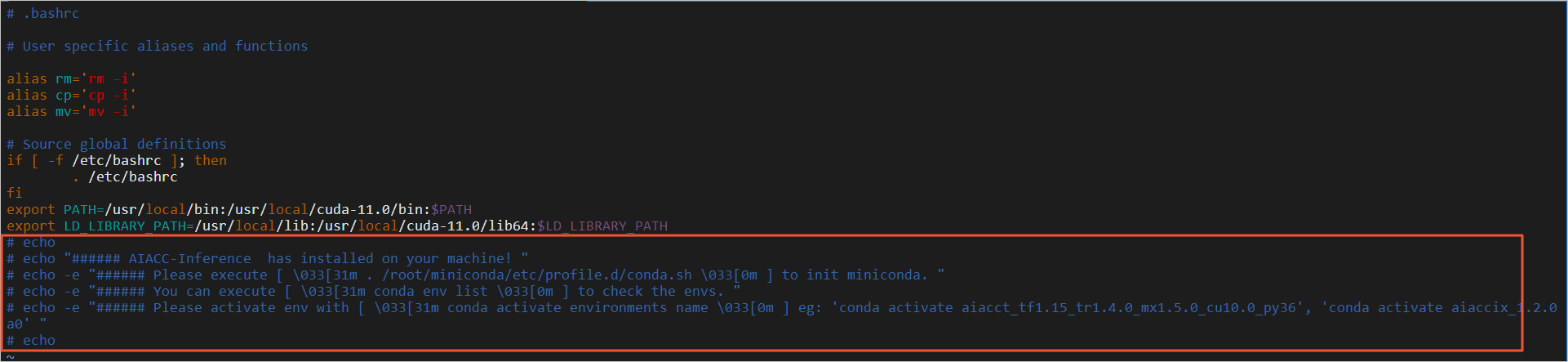

AIACC-Inference(AIACC推理加速)依赖GPU驱动、CUDA和cuDNN,请在创建GPU实例时,选中安装GPU驱动和AIACC推理加速,然后选择CUDA、Driver和cuDNN的版本。GPU实例创建完成后,您可以根据CUDA版本快速配置包含AIACC-Inference(AIACC推理加速)的Conda环境。创建GPU实例的具体操作,请参见创建配备NVIDIA GPU的实例。

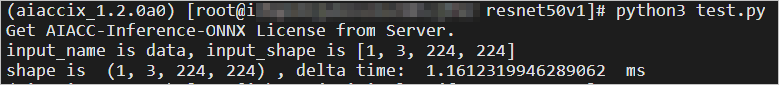

测试demo

删除Miniconda

如果您不需要使用AIACC-Inference(AIACC推理加速),可以删除Miniconda。默认为root用户安装Miniconda,为root用户删除Miniconda即可。

在线客服(工作时间:9:00-22:00)

在线客服(工作时间:9:00-22:00)